Date: 21 4 月, 2022

標籤: Google雲端平台

使用 SIOS DataKeeper for Windows 測量和提高 GCP 上的寫入吞吐量性能

背景

這篇文章用於記錄我在 GCP 中關於將性能寫入複製到 GCP 的磁盤的發現。 但首先,一些背景信息。 一位客戶表示擔心,在同一區域的 Google 區域之間使用同步鏡像進行測試時,DataKeeper 會為其寫入性能增加大量開銷。 他們執行的原始測試是使用 C 驅動器上的位圖文件,這是一個持久的 SSD。 在這種配置中,他們只推動了大約 70 MBps。 他們嘗試將位圖重新定位到一個極端的 GCP 磁盤,但性能並沒有提高。

將位圖移動到本地 SSD

我建議他們將位圖移動到本地 SSD,但他們猶豫不決,因為他們認為他們用於位圖的極端磁盤的延遲和吞吐量與本地 SSD 一樣好或更好,因此他們懷疑它是否會不同之處。 此外,添加本地 SSD 並非易事,因為它只能在最初配置 VM 時添加。

選擇實例類型

當我著手完成我的任務時,我發現的第一件事是並非所有實例類型都支持本地 SSD。 例如,E2-Standard-8 不支持本地 SSD。 在我的第一個測試中,我選擇了一種 C2-Standard-8 實例類型,它被認為是“計算優化的”。 我連接了一個 500 GB 的持久 SSD 並開始運行一些寫入性能測試,很快發現我只能讓磁盤以大約 140MBps 的速度寫入,而不是最大速度 240MBps。 客戶確認他們看到了同樣的東西。 這很令人困惑,但我們決定繼續嘗試不同的實例類型。

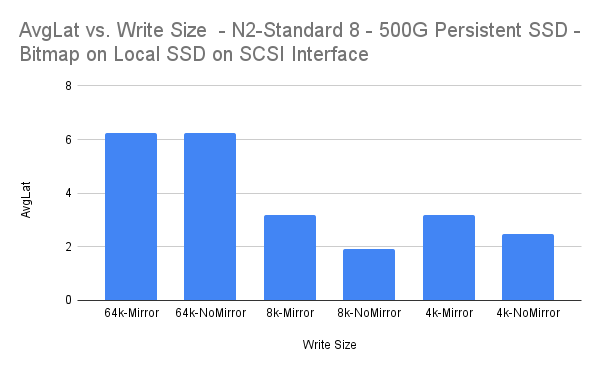

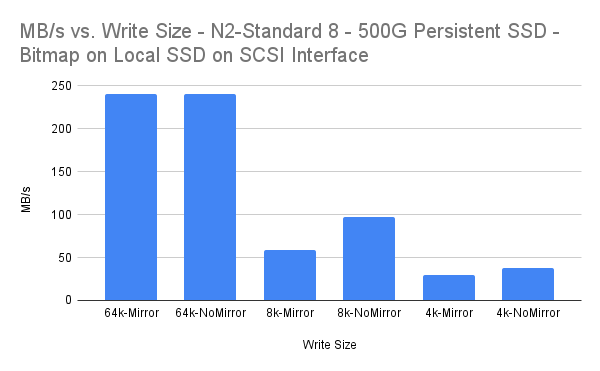

我們選擇的第二種實例類型是 N2-Standard-8。 使用這種實例類型,我們能夠在不復制磁盤時將磁盤推到其最大吞吐速度 240 MBps。 我將位圖移動到我已配置的本地 SSD 並在同步鏡像(DataKeeper v8.8.2)上重複相同的測試,並得到如下所示的結果。

結果

Diskspd測試參數diskspd.exe -c96G -d10 -r -w100 -t8 -o3 -b64K -Sh -LD:data.dat diskspd.exe -c96G -d10 -r -w100 -t8 -o3 -b8K -Sh -LD:data .dat diskspd.exe -c96G -d10 -r -w100 -t8 -o3 -b4K -Sh -LD:data.dat

MBps

數據

| 寫入大小 | MB/s | MBps 開銷百分比 |

| 64k-鏡子 | 240.01 | 0.00% |

| 64k-無鏡 | 240.02 | |

| 8k-鏡子 | 58.87 | 39.18% |

| 8k-無鏡 | 96.8 | |

| 4k-鏡子 | 29.34 | 21.84% |

| 4k-無鏡 | 37.54 |

| 寫入大小 | 平均緯度 | 平均開銷 |

| 64k-鏡子 | 6.247 | -0.02% |

| 64k-無鏡 | 6.248 | |

| 8k-鏡子 | 3.183 | 39.21% |

| 8k-無鏡 | 1.935 | |

| 4k-鏡子 | 3.194 | 21.88% |

| 4k-無鏡 | 2.495 |

結論

64k 和 4k 寫入大小都會產生開銷,這對於同步複製來說是“可接受的”。 儘管 3.183 毫秒的平均延遲仍然相當低,但 8k 寫入大小似乎會產生更大的開銷。

-Dave Bermingham,客戶成功總監 經許可轉載西歐