Date: 4월 21, 2022

태그: Google Cloud Platform

Windows용 SIOS DataKeeper를 사용하여 GCP에서 쓰기 처리량 성능 측정 및 개선

배경

이 게시물은 GCP에 복제되는 디스크에 대한 쓰기 성능과 관련하여 GCP에서 발견한 내용을 문서화하는 데 사용됩니다. 그러나 먼저 몇 가지 배경 정보가 있습니다. 한 고객은 동일한 지역의 Google 영역 간에 동기식 미러로 테스트할 때 DataKeeper가 쓰기 성능에 엄청난 양의 오버헤드를 추가하고 있다는 우려를 표명했습니다. 그들이 수행한 원래 테스트는 영구 SSD인 C 드라이브의 비트맵 파일을 사용하는 것이었습니다. 이 구성에서는 약 70MBps만 푸시했습니다. 그들은 비트맵을 극단적인 GCP 디스크로 재배치하려고 시도했지만 성능이 향상되지 않았습니다.

비트맵을 로컬 SSD로 이동

비트맵을 로컬 SSD로 옮기자고 제안했지만 비트맵에 사용하는 익스트림 디스크의 지연 시간과 처리량이 로컬 SSD와 같거나 더 우수하다고 생각하여 주저했습니다. 차이점. 또한 로컬 SSD를 추가하는 것은 VM이 원래 프로비저닝된 경우에만 추가할 수 있기 때문에 간단한 작업이 아닙니다.

인스턴스 유형 선택

작업을 완료하기 시작하면서 가장 먼저 발견한 것은 모든 인스턴스 유형이 로컬 SSD를 지원하는 것은 아니라는 것입니다. 예를 들어 E2-Standard-8은 로컬 SSD를 지원하지 않습니다. 첫 번째 테스트에서는 "컴퓨팅 최적화"로 간주되는 C2-Standard-8 인스턴스 유형으로 결정했습니다. 500GB 영구 SSD를 연결하고 몇 가지 쓰기 성능 테스트를 실행하기 시작했고 최대 속도 240MBps가 아닌 약 140MBps에서만 디스크를 쓸 수 있다는 것을 빠르게 발견했습니다. 고객은 동일한 것을 보았다고 확인했습니다. 당혹스러웠지만 계속해서 다른 인스턴스 유형을 시도하기로 결정했습니다.

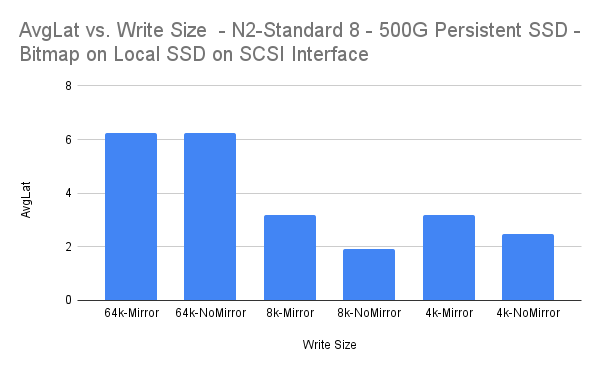

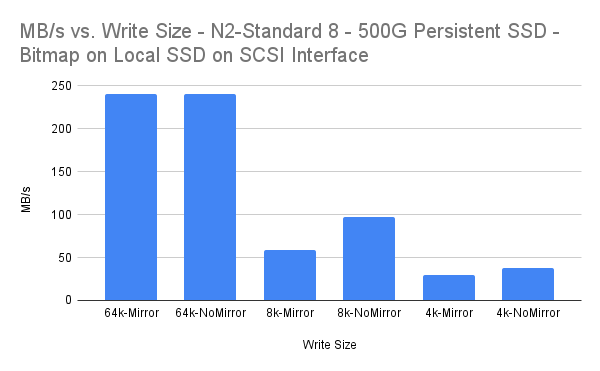

우리가 선택한 두 번째 인스턴스 유형은 N2-Standard-8입니다. 이 인스턴스 유형을 사용하면 디스크를 복제하지 않을 때 최대 처리 속도인 240MBps까지 디스크를 푸시할 수 있습니다. 비트맵을 프로비저닝한 로컬 SSD로 이동하고 동기식 미러(DataKeeper v8.8.2)에서 동일한 테스트를 반복하여 아래와 같은 결과를 얻었습니다.

결과

Diskspd 테스트 매개변수 diskspd.exe -c96G -d10 -r -w100 -t8 -o3 -b64K -Sh -LD:data.dat diskspd.exe -c96G -d10 -r -w100 -t8 -o3 -b8K -Sh -LD:data .dat diskspd.exe -c96G -d10 -r -w100 -t8 -o3 -b4K -Sh -LD:data.dat

MBps

자료

| 쓰기 크기 | MB/초 | MBps 백분율 오버헤드 |

| 64k 미러 | 240.01 | 0.00% |

| 64k-미러 없음 | 240.02 | |

| 8k 미러 | 58.87 | 39.18% |

| 8k-미러 없음 | 96.8 | |

| 4k 미러 | 29.34 | 21.84% |

| 4k-미러 없음 | 37.54 |

| 쓰기 크기 | 평균 위도 | 평균 위도 오버헤드 |

| 64k 미러 | 6.247 | -0.02% |

| 64k-미러 없음 | 6.248 | |

| 8k 미러 | 3.183 | 39.21% |

| 8k-미러 없음 | 1.935 | |

| 4k 미러 | 3.194 | 21.88% |

| 4k-미러 없음 | 2.495 |

결론

64k 및 4k 쓰기 크기는 모두 동기 복제에 "허용되는" 것으로 간주될 수 있는 오버헤드를 발생시킵니다. 평균 대기 시간 3.183ms는 여전히 매우 낮지만 8k 쓰기 크기는 더 많은 오버헤드를 발생시키는 것으로 보입니다.

-Dave Bermingham, 고객 성공 담당 이사의 허가를 받아 복제됨 시오스